11/08/2021 - 8:48

Suponha que alguém programe um sistema de inteligência artificial (IA) com inteligência superior à dos humanos, para que possa aprender de forma independente.

+ Descoberta oficina de cobre de 6.500 anos no deserto em Israel

+ Tomografia revela que múmias egípcias não são humanas

+ Conheça o phloeodes diabolicus “o besouro indestrutível”

Conectada à internet, a IA pode ter acesso a todos os dados da humanidade.

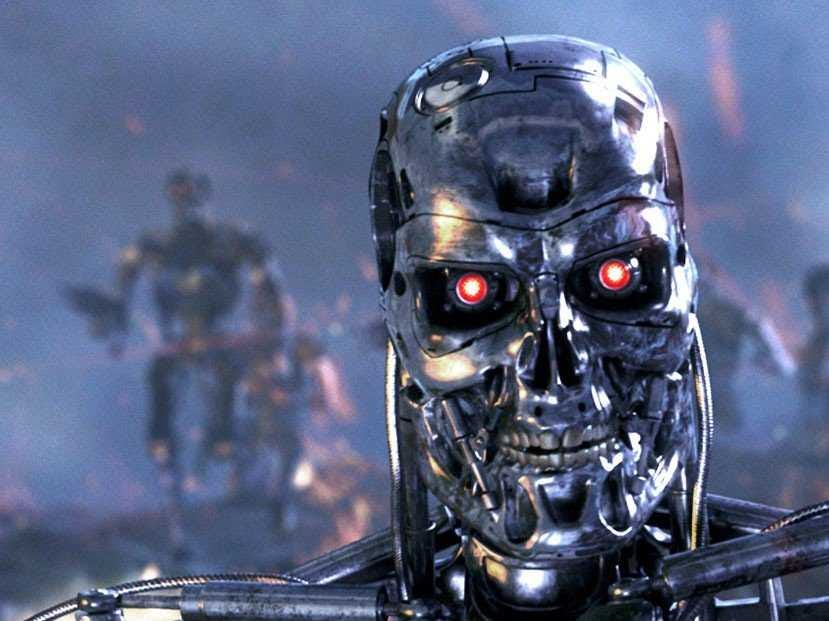

Ela poderia substituir todos os programas existentes e assumir o controle de todas as máquinas online em todo o mundo. Isso produziria uma utopia ou distopia? A IA curaria o câncer, traria a paz mundial e evitaria um desastre climático? Ou iria destruir a humanidade e assumir o controle da Terra, como especulam a cinessérie O Exterminador do Futuro e outras obras de ficção científica?

Cientistas da computação e filósofos se perguntaram se seríamos mesmo capazes de controlar uma IA superinteligente, para garantir que não representasse uma ameaça para a humanidade. Uma equipe internacional de cientistas da computação – Manuel Alfonseca, da Universidade Autônoma de Madri (Espanha), Manuel Cebrian e Iyad Rahwan, do Instituto Max Planck para o Desenvolvimento Humano (Alemanha), Antonio Fernandez Anta, do IMDEA Networks Institute (Espanha), Lorenzo Coviello, do Massachusetts Institute of Technology (EUA), e Andrés Abeliuk, da Universidade do Sul da Califórnia (EUA) – usou cálculos teóricos para mostrar que seria fundamentalmente impossível controlar uma IA superinteligente. O estudo foi publicado na revista “Journal of Artificial Intelligence Research”.

- Inteligência artificial resolve cubo mágico em menos de um segundo

- Diagnóstico de inteligência artificial já iguala o de médicos humanos

Independência em tarefas

“Uma máquina superinteligente que controla o mundo parece ficção científica. Mas já existem máquinas que realizam certas tarefas importantes de forma independente, sem que os programadores entendam totalmente como as aprenderam. Portanto, surge a questão de saber se isso poderia em algum momento se tornar incontrolável e perigoso para humanidade”, diz Cebrian.

Os cientistas exploraram duas ideias diferentes de como uma IA superinteligente pode ser controlada. Por um lado, as capacidades da IA superinteligente poderiam ser especificamente limitadas, por exemplo, privando-a da internet e de todos os outros dispositivos técnicos para que não pudesse ter contato com o mundo exterior – mas isso tornaria a IA superinteligente significativamente menor poderosa, menos capaz de responder às buscas da humanidade.

Sem essa opção, a IA poderia ser motivada desde o início a perseguir apenas objetivos que atendam aos melhores interesses da humanidade, por exemplo, a partir da programação de princípios éticos nela. No entanto, os pesquisadores também mostram que essas e outras ideias contemporâneas e históricas para controlar a IA superinteligente têm seus limites.

Sem solução

Em seu estudo, a equipe concebeu um algoritmo de contenção teórica que garante que uma IA superinteligente não possa prejudicar as pessoas em nenhuma circunstância, simulando o comportamento da IA primeiro e interrompendo-o se ele fosse considerado prejudicial. Mas uma análise cuidadosa mostra que, em nosso paradigma atual de computação, esse algoritmo não pode ser construído.

“Se você dividir o problema em regras básicas da ciência da computação teórica, descobre que um algoritmo que comandaria uma IA para não destruir o mundo poderia inadvertidamente interromper suas próprias operações. Se isso acontecesse, você não saberia se o algoritmo de contenção ainda está analisando a ameaça ou se ela parou para conter a IA prejudicial. Na verdade, isso torna o algoritmo de contenção inutilizável”, disse Iyad Rahwan.

Com base nesses cálculos, o problema de contenção é incomputável, ou seja, nenhum algoritmo pode encontrar uma solução para determinar se uma IA produziria danos ao mundo. Além disso, os pesquisadores demonstram que podemos nem saber quando as máquinas superinteligentes chegaram, porque decidir se uma máquina exibe inteligência superior aos humanos está no mesmo reino do problema de contenção.